|

EN BREF

|

Depuis les calculs rudimentaires de l’Antiquité jusqu’à l’ère numérique d’aujourd’hui, l’histoire de l’informatique est un fascinant voyage à travers le temps. Cette discipline, qui émergea d’une combinaison de mathématiques et de physique, a vu des visionnaires comme Charles Babbage conceptualiser des machines capables de transformer notre façon de manipuler l’information. Du premier ordinateur commercial en 1951 à la démocratisation des micro-ordinateurs dans les années 1980, chaque innovation a ouvert de nouvelles perspectives et réinventé notre rapport à la technologie. Plongeons ensemble dans cette aventure captivante, qui nous révèle comment l’informatique a façonné notre quotidien et continue de redéfinir notre avenir.

L’histoire de l’informatique est une aventure fascinante qui nous transporte des premiers calculs de l’Antiquité jusqu’à l’ère numérique actuelle. Ce voyage à travers le temps met en lumière des innovations spectaculaires, des personnalités marquantes et des idées révolutionnaires qui ont façonné ce domaine et continuent d’alimenter notre quotidien. Découvrons ensemble ce parcours incroyable qui a permis à l’informatique de devenir l’un des piliers de notre ère moderne.

Les débuts de l’informatique

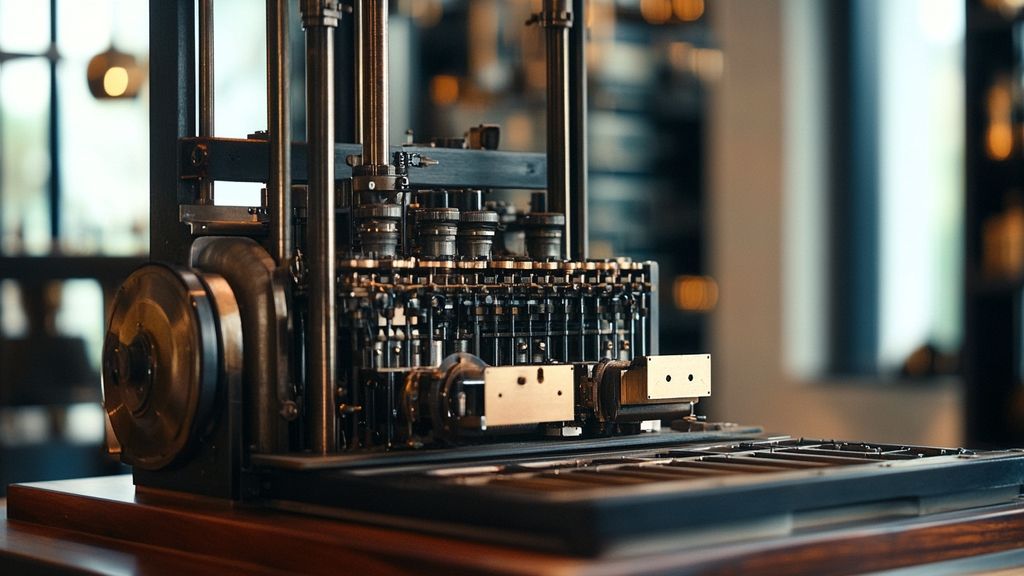

Les racines de l’informatique plongent bien avant l’ère moderne, remontant à des siècles d’innovations en mathématiques et en physique. Dès l’Antiquité, les premières civilisations ont utilisé des outils tels que l’abaque pour effectuer des calculs. Puis, au cours du XIXe siècle, Charles Babbage a conceptualisé ce qui est souvent considéré comme le premier calculateur programmable, la machine analytique. Cette invention audacieuse a posé les fondations de ce que nous connaissons aujourd’hui comme l’informatique.

L’essor des automates au XIXe siècle

Au fur et à mesure que nous entrons dans le XIXe siècle, l’essor des automates a marqué une étape clé. L’invention du métiers à tisser de Joseph Marie Jacquard en 1801 a introduit le concept de programmation à travers des cartes perforées. Ce principe a inspiré de futures innovations, et Babbage s’est appuyé sur cette idée pour sa propre machine. Ainsi, l’automatisation du travail a ouvert la voie à des méthodes de calcul et de stockage de données qui seraient cruciales trois siècles plus tard.

L’informatique moderne et les premières machines

C’est dans les années 1930 que l’informatique moderne a commencé à prendre forme. En 1936, le mathématicien Alan Turing a proposé la notion de « machine de Turing », un concept théorique qui pose les bases de l’informatique en tant que discipline. Par la suite, l’Université de Pennsylvanie a mis au point l’ENIAC, le premier ordinateur électronique généraliste, qui a été achevé en 1945. Les années suivantes ont vu l’émergence d’autres machines, notamment le UNIVAC en 1951, le premier ordinateur commercial.

Des années 1960 aux années 1980 : l’alerte des langages de programmation

Les années 1960 ont été marquées par le développement de nouveaux langages de programmation, tels que FORTRAN et COBOL. Ces innovations ont permis aux développeurs de communiquer plus efficacement avec les machines. Parallèlement, l’émergence de l’Intel 4004 en 1971, le premier microprocesseur, a transformé le paysage technologique. Les prototypes de micro-ordinateurs ont commencé à apparaître sur le marché, donnant naissance à une nouvelle époque d’informatique personnelle.

L’essor des ordinateurs personnels

Avec le lancement du PC d’IBM en 1981, un nouveau chapitre de l’histoire de l’informatique s’est ouvert. Les ordinateurs personnels sont devenus accessibles au grand public, révolutionnant la façon dont les gens interagissaient avec le monde numérique. Cette décennie a également vu la montée des systèmes d’exploitation, dont le célèbre MS-DOS qui a servi de fondation pour de nombreuses applications.

Les avancées de l’ère Internet

La fin des années 1990 a apporté avec elle l’explosion de l’Internet. Ce réseau mondial a ouvert les portes d’un nouveau monde d’opportunités, permettant la communication instantanée et le partage d’informations à une échelle jamais vue auparavant. L’arrivée du World Wide Web a aussi permis l’émergence de nombreuses entreprises, créant un bouleversement dans plusieurs secteurs et contribuant à façonner la « révolution numérique ».

Les défis et l’avenir de l’informatique

Dans le monde d’aujourd’hui, des avancées telles que l’intelligence artificielle suscitent des passions mais posent aussi des questions éthiques. Plusieurs experts, dont certains militent pour une utilisation responsable de ces technologies, se demandent comment l’IA influencera notre quotidien. La nécessité de discuter de l’impact sociétal des nouvelles technologies est plus que jamais d’actualité. Pour une exploration plus approfondie sur cette problématique, vous pouvez visiter ce lien sur les théorèmes mathématiques qui ont eu un impact notable ou découvrir la beauté et la complexité des fractales qui illustrent également des concepts fondamentaux en informatique. Sans oublier l’importance des nombres premiers dans le développement de la cryptographie et de la sécurité en ligne.

Il est indéniable que l’histoire de l’informatique est intrinsèquement liée à celle de l’humanité, marquée par des découvertes sans précédent. En regardant vers l’avenir, nous pouvons être assurés que le domaine continuera d’évoluer, apportant son lot d’innovations et d’interrogations sur la façon dont elles seront intégrées dans nos vies quotidiennes.

L’évolution des Inventions Informatiques

| Date | Invention Clé |

| 1801 | Invention du médaillon à tisser par Joseph Marie Jacquard, première machine à programmation. |

| 1834 | Charles Babbage conçoit la machine analytique, préfigurant l’ordinateur moderne. |

| 1936 | Alan Turing propose le concept de la machine de Turing, fondement de la computation moderne. |

| 1951 | Lancement de l’UNIAC, premier ordinateur commercialisé. |

| 1962 | Le terme informatique est créé, fusionnant l’information et l’automatique. |

| 1971 | Lancement du Intel 4004, premier microprocesseur. |

| 1981 | IBM introduit le PC, démocratisant l’accès à l’informatique. |

| 1991 | Sortie du Web, révolutionnant l’accès à l’information. |

| 2004 | Apparition de l’Intelligence Artificielle dans les foyers avec des assistants vocaux. |

| Présent | Débats sur l’éthique de l’IA et son impact sociétal. |

Que vous soyez un passionné de technologie ou simplement curieux du monde moderne, l’histoire de l’informatique est une épopée fascinante qui mérite d’être explorée. Des simples calculs à l’ère des intelligences artificielles, l’évolution de cette discipline a profondément changé notre quotidien. Plongeons ensemble dans les méandres de l’informatique, des débuts jusqu’à nos jours.

Les débuts : des fondations mathématiques

Les racines de l’informatique sont ancrées dans les mathématiques et la physique, bien avant que le terme même d’informatique n’émerge. Des civilisations anciennes utilisaient déjà des outils pour effectuer des calculs, mais c’est au XIXe siècle que les premières machines automatisées commencent à faire leur apparition. Charles Babbage, souvent qualifié de grand-père de l’informatique, a conceptualisé la machine analytique, une préfigurante de l’ordinateur moderne.

Le XXe siècle : l’ère des calculateurs

La première moitié du XXe siècle marque un tournant décisif avec l’apparition des premiers calculateurs électroniques. En 1936, Alan Turing pose les bases de la théorie de la computation, révolutionnant ce qu’étaient capables de faire les machines. En 1951, l’UNIVAC, le premier ordinateur commercial, voit le jour, rendant l’informatique accessible à un plus grand public.

L’explosion de la micro-informatique

Les années 1980 ont été témoins d’une véritable révolution informatique grâce à l’émergence des micro-ordinateurs. L’arrivée du PC d’IBM et du Commodore 64 crée un engouement sans précédent. À cette époque, l’informatique devient un outil indispensable pour les entreprises, mais également pour le grand public. Les premiers langages de programmation comme BASIC deviennent populaires, ouvrant la voie à une nouvelle génération de développeurs.

Du numérique à l’intelligence artificielle

Au fil des décennies, l’informatique a évolué pour donner naissance à des technologies avancées. L’intelligence artificielle, aujourd’hui sur toutes les lèvres, représente l’apogée de cette évolution. Les algorithmes complexes, les systèmes de recommandation et même les assistants vocaux, tout cela repose sur les fondements posés par nos ancêtres en informatique. Découvrez comment les mathématiques alliées à la technologie façonnent notre futur sur ce lien et plongez dans les concepts fascinants des fractales sur ceux-ci.

À l’horizon : l’avenir de l’informatique

En regardant vers l’avenir, l’informatique continue de se réinventer. Des technologies comme la blockchain, l’Internet des Objets et l’ordinateur quantique promettent de transformer encore davantage notre rapport à la technologie. L’informatique n’est pas qu’une série de machines, mais une véritable révolution culturelle qui influence tous les aspects de notre société.

L’histoire de l’informatique est fascinante et complexe, enracinée dans des siècles d’évolution technologique, de la simple addition à la puissance des ordinateurs modernes. Cet article plonge dans les grandes étapes de cette discipline, qui a révolutionné notre manière de communiquer, d’apprendre et de travailler. En explorant les précurseurs, les avancées majeures et les défis contemporains, nous mettons en lumière les personnalités et les inventions qui ont façonné le monde numérique tel que nous le connaissons aujourd’hui.

Les Origines de l’Informatique

L’informatique ne naît pas du vide. Ses racines remontent à des inventions mathématiques et mécaniques de l’Antiquité. Les premiers calculs se faisaient à l’aide de bâtons de comptage ou de boules sur un abaque. Au cours des siècles, des chiffres et des algorithmes ont progressivement émergé comme des outils indispensables pour les mathématiciens et les astronomes.

Au début du 19ème siècle, l’inventeur britannique Charles Babbage conceptualisa la première machine programmable, connue sous le nom de machine analytique. Bien qu’elle ne fut jamais achevée, cette idée novatrice posait les bases de ce que nous appelons aujourd’hui l’ordinateur moderne.

Le 20ème Siècle : L’Émergence de l’Informatique Moderne

Le véritable tournant eut lieu au 20ème siècle, avec l’apparition des premiers automates et calculateurs. En 1943, la machine ENIAC vit le jour, marquant le début de l’ère des ordinateurs électroniques. Capable d’effectuer des millions de calculs en une seconde, elle pose les fondations de l’informatique moderne.

Puis vint le premier microprocesseur d’Intel, le 4004, en 1971. Ce développant son usage, suivit de près par la commercialisation du premier ordinateur personnel en 1981 par IBM. Ici, l’informatique image un passage d’une niche technologique à quelque chose d’absolument relié à la vie quotidienne.

Les Années 2000 : La Révolution Numérique

Les années 2000 marquent un grand bond dans l’intégration de l’informatique dans notre vie quotidienne. Avec l’avènement d’Internet, l’accès à l’information devient instantané. Des géants comme Google, Facebook et Amazon surgissent, transformant la manière de consommer et d’interagir. Les réseaux sociaux s’imposent comme une nouvelle forme de communication, réduisant les distances entre les gens à une simple connexion.

Cette époque est aussi le théâtre d’une explosion des technologies mobiles, rendant l’information accessible dans la paume de nos mains. Les smartphones et tablettes deviennent des outils omniprésents, intégrant des applications pour presque tous les besoins. Cette omniprésence entraîne des débats éthiques et sociétaux autour de la protection des données et de l’impact des technologies sur notre vie privée.

Les Défis Contemporains : Vers une Informatique Éthique

À la croisée des chemins, l’informatique fait face à des défis qui nécessitent une réflexion éthique sérieuse. L’essor de l’intelligence artificielle, avec ses impacts colossaux sur l’emploi et la vie personnelle, soulève de nombreuses questions. L’importance d’une approche éthique des technologies émergentes n’a jamais été aussi pressante. Des discussions sur l’équité algorithmique et la transparence des systèmes deviennent des sujets essentiels pour envisager un futur serein.

En somme, l’histoire de l’informatique est un voyage incroyable, ancré dans l’innovation, mais aussi accompagné de défis cruciales qui nécessitent un débat public. La prochaine étape de cette aventure passionnante dépend de notre capacité à balancer technologie et éthique pour construire un monde meilleur.

FAQ sur l’histoire de l’informatique

Q : Quand l’histoire de l’informatique a-t-elle vraiment commencé ?

R : L’histoire de l’informatique s’est amorcée bien avant que la discipline moderne ne prenne forme, et elle est souvent liée aux avancées en mathématiques et physique.

Q : Qui est considéré comme le père de l’informatique ?

R : Charles Babbage est souvent désigné comme le « grand-père » de l’informatique pour ses contributions dans la conception des premières machines programmables.

Q : Quelles avancées majeures ont eu lieu au 19ème siècle concernant l’informatique ?

R : Au 19ème siècle, des inventions telles que le métier à tisser de Joseph Marie Jacquard (1801) ont posé les bases de la programmation, avec l’idée de mécanismes pouvant être contrôlés de manière séquentielle.

Q : Quel a été le premier ordinateur commercial ?

R : Le premier ordinateur commercial a été l’UNIAC, mis sur le marché en 1951.

Q : Quand le terme « informatique » a-t-il été créé ?

R : Le terme « informatique » a vu le jour en 1962, grâce à Philippe Dreyfus, en combinant les mots information et automatique.

Q : Comment l’informatique a-t-elle évolué au fil des décennies ?

R : L’évolution de l’informatique a été marquée par des sauts technologiques, comme la création du premier microprocesseur, l’Intel 4004, suivi de divers prototypes de micro-ordinateurs dans les années 70.

Q : Quelle est l’importance des théories de programmation dans l’histoire de l’informatique ?

R : Les théories de programmation sont essentielles car elles ont permis le développement de langages et de techniques pour écrire des programmes, ce qui a propulsé l’informatique moderne.